AI Toolkit에서 모델 탐색

AI Toolkit은 소형 언어 모델(SLM) 및 대형 언어 모델(LLM)을 포함한 다양한 생성형 AI 모델을 포괄적으로 지원합니다.

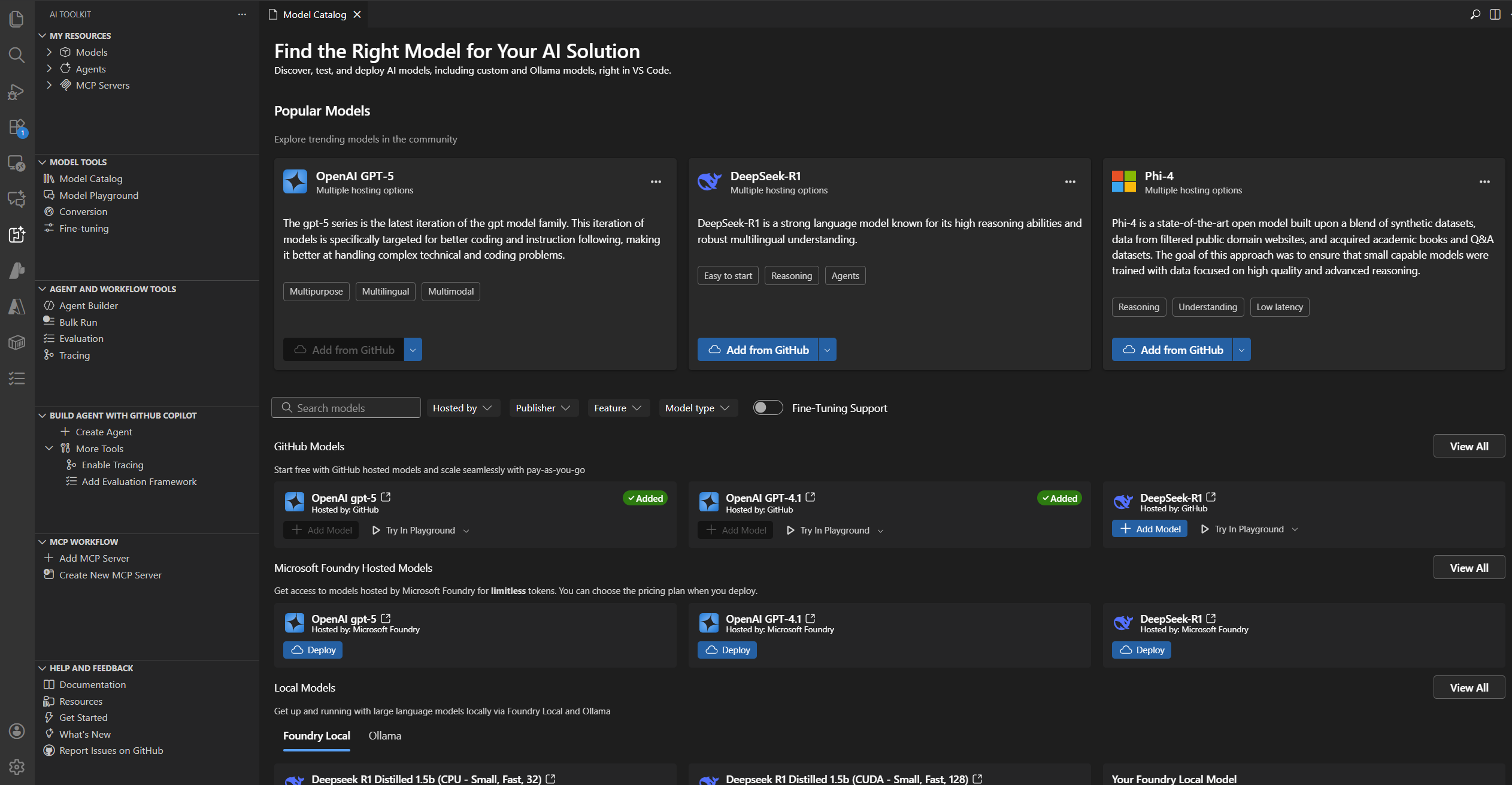

모델 카탈로그 내에서 여러 호스팅 소스의 모델을 탐색하고 활용할 수 있습니다.

- Llama3, Phi-3, Mistral과 같은 GitHub에 호스팅된 모델(종량제 옵션 포함).

- OpenAI의 ChatGPT, Anthropic의 Claude, Google의 Gemini를 포함한 게시자가 직접 제공하는 모델.

- Microsoft Foundry에 호스팅된 모델.

- Ollama 및 ONNX와 같은 리포지토리에서 로컬로 다운로드한 모델.

- Bring-Your-Own-Model(BYOM) 통합을 통해 액세스할 수 있는 사용자 지정 자체 호스팅 또는 외부 배포 모델.

모델 카탈로그 내에서 직접 Foundry에 모델을 배포하여 워크플로를 간소화합니다.

AI Toolkit에 추가된 Microsoft Foundry, Foundry Local 및 GitHub 모델을 GitHub Copilot과 함께 사용하세요. 자세한 내용은 채팅 대화 모델 변경을 참조하세요.

모델 찾기

모델 카탈로그에서 모델을 찾으려면

-

활동 표시줄에서 AI Toolkit 보기를 선택합니다.

-

모델 > 카탈로그를 선택하여 모델 카탈로그를 엽니다.

-

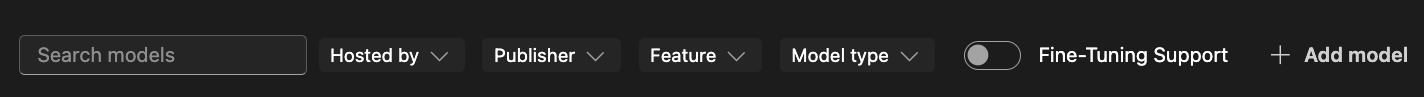

필터를 사용하여 사용 가능한 모델 목록을 줄입니다.

- 호스팅 제공자: AI Toolkit은 GitHub, ONNX, OpenAI, Anthropic, Google을 모델 호스팅 소스로 지원합니다.

- 게시자: Microsoft, Meta, Google, OpenAI, Anthropic, Mistral AI 등과 같은 AI 모델의 게시자입니다.

- 기능:

텍스트 첨부,이미지 첨부,웹 검색,구조화된 출력등과 같은 모델의 지원 기능입니다. - 모델 유형: 원격 또는 로컬 CPU, GPU 또는 NPU에서 실행할 수 있는 모델을 필터링합니다. 이 필터는 로컬 가용성에 따라 달라집니다.

- 미세 조정 지원: 미세 조정을 실행하는 데 사용할 수 있는 모델을 표시합니다.

-

다양한 범주의 모델을 찾아보세요. 예를 들어

- 인기 모델은 다양한 작업 및 도메인에서 널리 사용되는 모델의 큐레이션된 목록입니다.

- GitHub 모델은 GitHub에 호스팅된 인기 모델에 쉽게 액세스할 수 있도록 제공합니다. 빠른 프로토타이핑 및 실험에 가장 적합합니다.

- ONNX 모델은 로컬 실행에 최적화되어 있으며 CPU, GPU 또는 NPU에서 실행할 수 있습니다.

- Ollama 모델은 Ollama를 사용하여 로컬에서 실행할 수 있는 인기 있는 모델이며 CPU는 GGUF 양자화를 통해 지원합니다.

-

또는 검색 상자를 사용하여 이름이나 설명으로 특정 모델을 찾습니다.

카탈로그에서 모델 추가

모델 카탈로그에서 모델을 추가하려면

-

모델 카탈로그에서 추가하려는 모델을 찾습니다.

-

모델 카드에서 추가를 선택합니다.

-

모델을 추가하는 흐름은 제공업체에 따라 약간 다릅니다.

-

GitHub: AI Toolkit은 모델 리포지토리에 액세스하기 위해 GitHub 자격 증명을 요청합니다. 인증되면 모델이 AI Toolkit에 직접 추가됩니다.

참고AI Toolkit은 이제 GitHub 종량제 모델을 지원하므로 무료 등급 제한을 초과한 후에도 계속 작업할 수 있습니다.

-

ONNX: 모델이 ONNX에서 다운로드되어 AI Toolkit에 추가됩니다.

-

Ollama: 모델이 Ollama에서 다운로드되어 AI Toolkit에 추가됩니다.

팁나중에 모델을 마우스 오른쪽 버튼으로 클릭하고 편집을 선택하여 API 키를 편집하고 암호화된 값을

${HOME}/.aikt/models/my-models/yml파일에서 볼 수 있습니다.

-

OpenAI, Anthropic, Google: AI Toolkit에서 API 키 입력을 요청합니다.

-

사용자 지정 모델: 자세한 지침은 사용자 지정 모델 추가 섹션을 참조하세요.

-

추가되면 모델이 트리 보기의 내 모델 아래에 표시되며 플레이그라운드 또는 에이전트 빌더에서 사용할 수 있습니다.

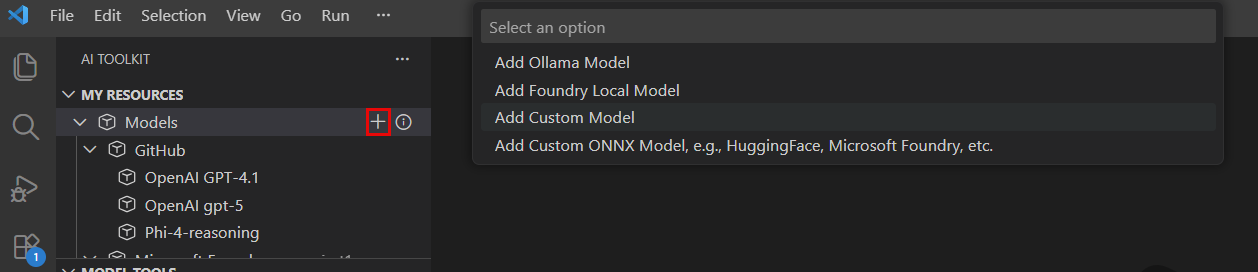

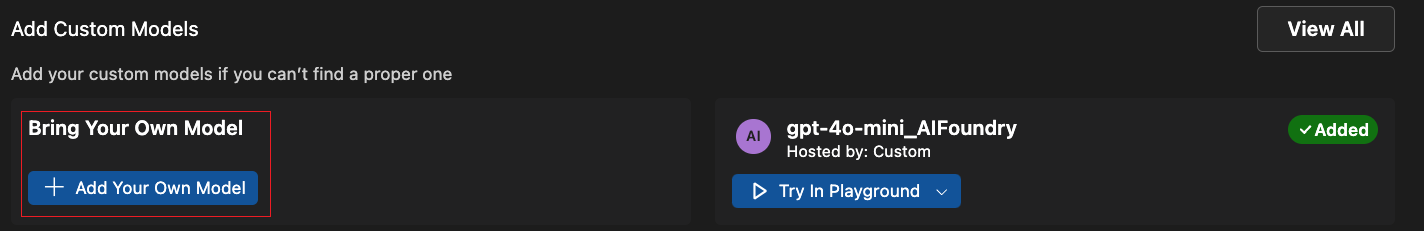

사용자 지정 모델 추가

외부에서 호스팅되거나 로컬에서 실행되는 자체 모델을 추가할 수도 있습니다. 몇 가지 옵션을 사용할 수 있습니다.

- Ollama 라이브러리 또는 사용자 지정 Ollama 엔드포인트에서 Ollama 모델을 추가합니다.

- 자체 호스팅되거나 클라우드 서비스에서 실행되는 모델과 같이 OpenAI 호환 엔드포인트가 있는 사용자 지정 모델을 추가합니다.

- AI Toolkit의 모델 변환 도구를 사용하여 Hugging Face의 모델과 같은 사용자 지정 ONNX 모델을 추가합니다.

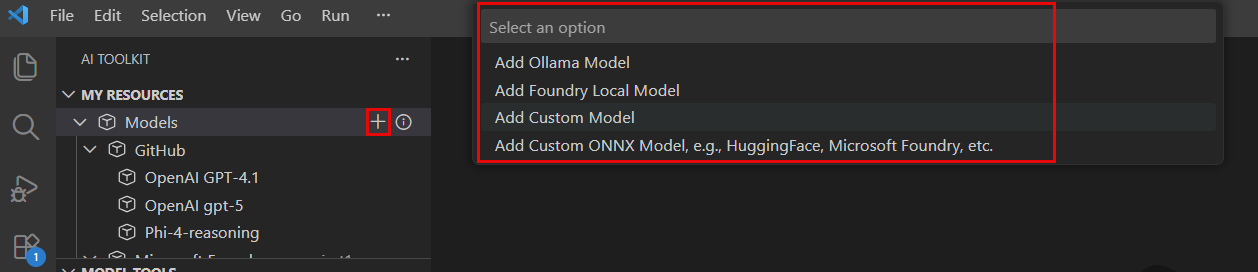

AI Toolkit에 모델을 추가하는 몇 가지 진입점이 있습니다.

-

트리 보기의 내 모델에서 마우스를 올리고

+아이콘을 선택합니다.

-

모델 카탈로그에서 도구 모음의 + 모델 추가 버튼을 선택합니다.

-

모델 카탈로그의 사용자 지정 모델 추가 섹션에서 + 나만의 모델 추가를 선택합니다.

Ollama 모델 추가

Ollama는 GGUF 양자화를 통해 CPU를 사용하여 많은 인기 있는 genAI 모델을 로컬에서 실행할 수 있도록 합니다. 로컬 컴퓨터에 다운로드된 Ollama 모델이 설치된 Ollama가 있는 경우 AI Toolkit에 추가하여 모델 플레이그라운드에서 사용할 수 있습니다.

AI Toolkit에서 Ollama 모델을 사용하기 위한 사전 요구 사항

- AI Toolkit v0.6.2 이상.

- Ollama (Ollama v0.4.1에서 테스트됨)

로컬 Ollama를 AI Toolkit에 추가하려면

-

위에 언급된 진입점 중 하나에서 Ollama 모델 추가를 선택합니다.

-

다음으로 Ollama 라이브러리에서 모델 선택을 선택합니다.

Ollama 런타임을 다른 엔드포인트에서 시작하는 경우 사용자 지정 Ollama 엔드포인트 제공을 선택하여 Ollama 엔드포인트를 지정합니다.

-

AI Toolkit에 추가할 모델을 선택한 다음 확인을 선택합니다.

참고AI Toolkit은 Ollama에 이미 다운로드되었지만 아직 AI Toolkit에 추가되지 않은 모델만 표시합니다. Ollama에서 모델을 다운로드하려면

ollama pull <model-name>을 실행할 수 있습니다. Ollama에서 지원하는 모델 목록을 보려면 Ollama 라이브러리를 참조하거나 Ollama 설명서를 참조하세요. -

이제 트리 보기의 모델 목록에서 선택한 Ollama 모델을 볼 수 있습니다.

참고Ollama 모델은 아직 첨부 파일이 지원되지 않습니다. Ollama에 OpenAI 호환 엔드포인트를 사용하여 연결하고 아직 첨부 파일을 지원하지 않기 때문입니다.

OpenAI 호환 엔드포인트가 있는 사용자 지정 모델 추가

인터넷에서 액세스할 수 있는 자체 호스팅 또는 배포된 모델에 OpenAI 호환 엔드포인트가 있는 경우 AI Toolkit에 추가하여 플레이그라운드에서 사용할 수 있습니다.

- 위의 진입점 중 하나에서 사용자 지정 모델 추가를 선택합니다.

- OpenAI 호환 엔드포인트 URL과 필요한 정보를 입력합니다.

자체 호스팅 또는 로컬에서 실행되는 Ollama 모델을 추가하려면

- 모델 카탈로그에서 + 모델 추가를 선택합니다.

- 모델 빠른 선택에서 Ollama 또는 사용자 지정 모델을 선택합니다.

- 모델을 추가하기 위해 필요한 세부 정보를 입력합니다.

사용자 지정 ONNX 모델 추가

사용자 지정 ONNX 모델을 추가하려면 먼저 모델 변환 도구를 사용하여 AI Toolkit 모델 형식으로 변환합니다. 변환 후 모델을 AI Toolkit에 추가합니다.

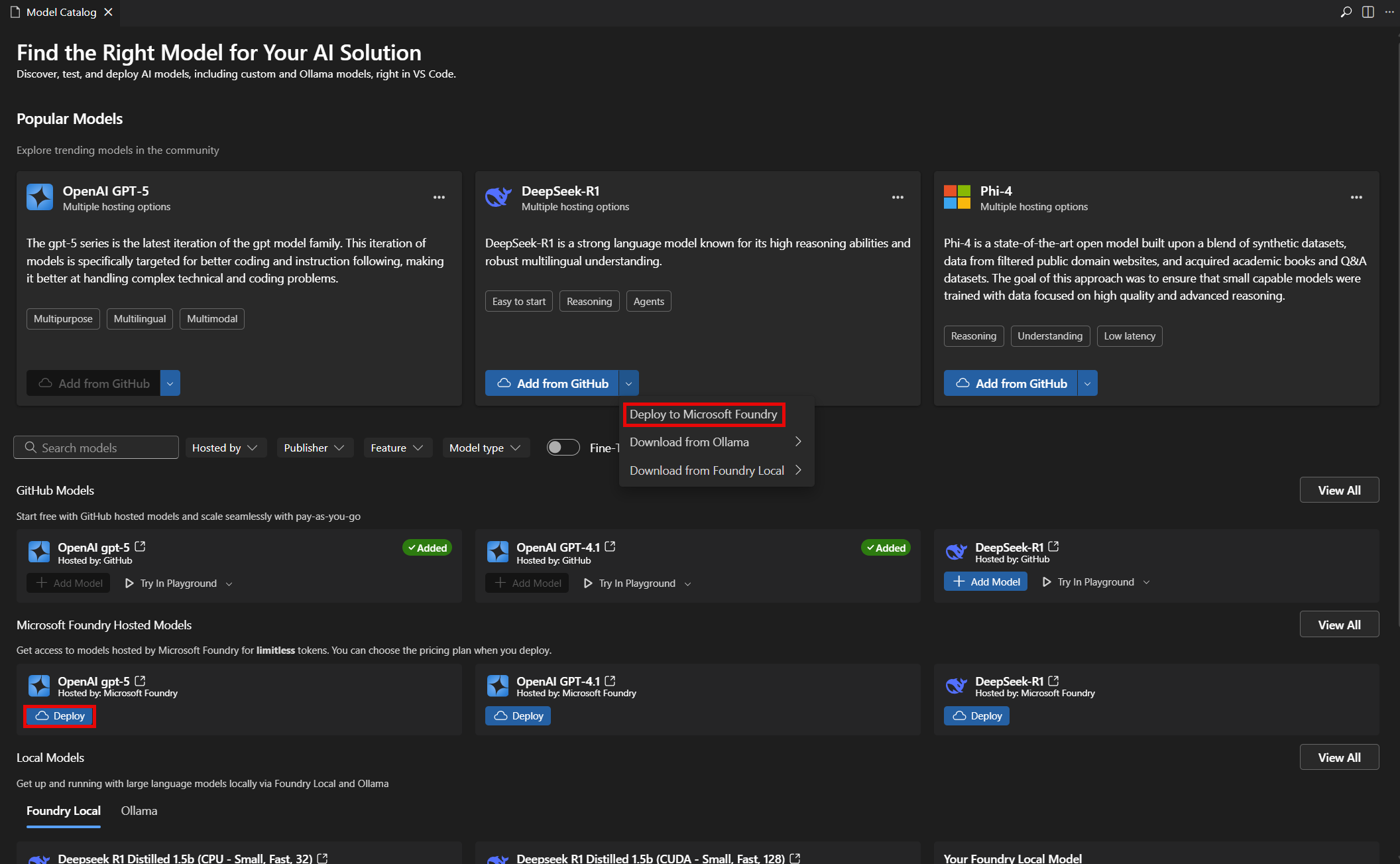

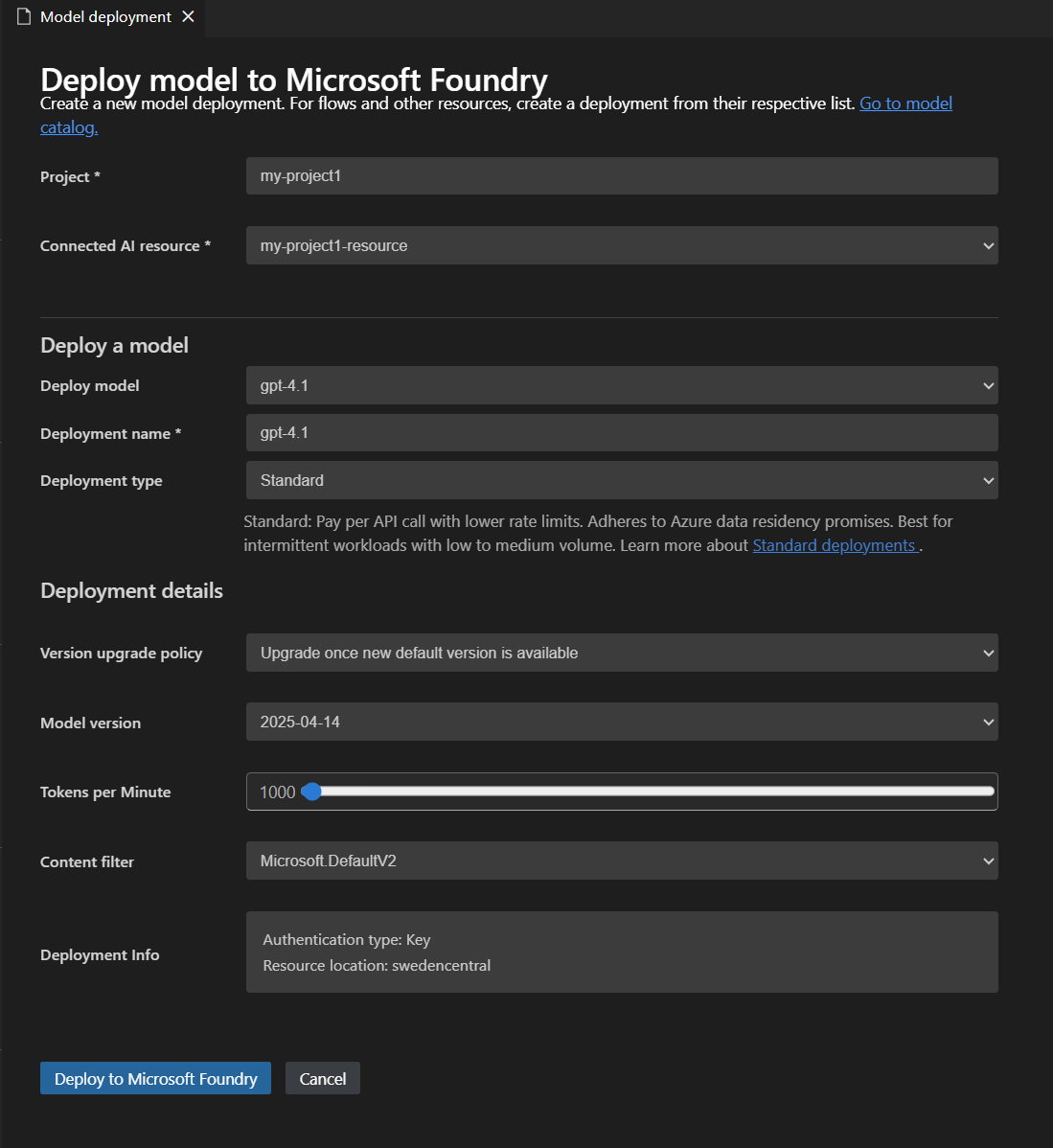

Microsoft Foundry에 모델 배포

AI Toolkit에서 직접 Microsoft Foundry에 모델을 배포할 수 있습니다. 이를 통해 클라우드에서 모델을 실행하고 엔드포인트를 통해 액세스할 수 있습니다.

-

모델 카탈로그에서 배포하려는 모델을 선택합니다.

-

다음 스크린샷과 같이 드롭다운 메뉴 또는 Microsoft Foundry에 배포 버튼에서 Microsoft Foundry에 배포를 선택합니다.

-

모델 배포 탭에서 다음 스크린샷과 같이 모델 이름, 설명 및 추가 설정과 같은 필요한 정보를 입력합니다.

-

Microsoft Foundry에 배포를 선택하여 배포 프로세스를 시작합니다.

-

배포를 확인하는 대화 상자가 나타납니다. 세부 정보를 검토하고 배포를 선택하여 진행합니다.

-

배포가 완료되면 모델이 AI Toolkit의 내 모델 섹션에서 사용 가능하며 플레이그라운드 또는 에이전트 빌더에서 사용할 수 있습니다.

테스트할 모델 선택

채팅 완료를 위해 플레이그라운드에서 모델을 테스트할 수 있습니다.

모델 카탈로그의 모델 카드에서 작업을 사용합니다.

- 플레이그라운드에서 사용: 플레이그라운드에서 테스트를 위해 선택한 모델을 로드합니다.

- 에이전트 빌더에서 사용: AI 에이전트를 구축하기 위해 에이전트 빌더에서 선택한 모델을 로드합니다.

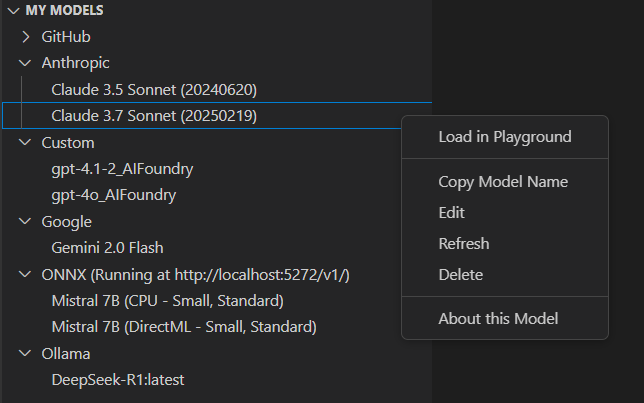

모델 관리

AI Toolkit 보기의 내 모델 섹션에서 모델을 관리할 수 있습니다. 여기에서 다음을 수행할 수 있습니다.

-

AI Toolkit에 추가한 모델 목록을 봅니다.

-

모델을 마우스 오른쪽 버튼으로 클릭하여 다음과 같은 옵션에 액세스합니다.

- 플레이그라운드에서 로드: 테스트를 위해 플레이그라운드에서 모델을 로드합니다.

- 모델 이름 복사: 다른 컨텍스트, 예를 들어 코드 통합에서 사용하기 위해 모델 이름을 클립보드에 복사합니다.

- 새로 고침: 최신 설정을 보장하기 위해 모델 구성을 새로 고칩니다.

- 편집: API 키 또는 엔드포인트와 같은 모델 설정을 수정합니다.

- 삭제: AI Toolkit에서 모델을 제거합니다.

- 이 모델 정보: 게시자, 소스 및 지원되는 기능을 포함한 모델에 대한 자세한 정보를 봅니다.

-

ONNX섹션 제목을 마우스 오른쪽 버튼으로 클릭하여 다음과 같은 옵션에 액세스합니다.- 서버 시작: ONNX 모델을 로컬에서 실행하기 위해 ONNX 서버를 시작합니다.

- 서버 중지: 실행 중인 경우 ONNX 서버를 중지합니다.

- 엔드포인트 복사: 다른 컨텍스트, 예를 들어 코드 통합에서 사용하기 위해 ONNX 서버 엔드포인트를 클립보드에 복사합니다.

라이선스 및 로그인

일부 모델은 게시자 또는 호스팅 서비스 라이선스 및 로그인 계정이 필요합니다. 이 경우 모델 플레이그라운드에서 모델을 실행하기 전에 이 정보를 제공하라는 메시지가 표시됩니다.

학습 내용

이 문서에서는 다음 방법을 배웠습니다.

- AI Toolkit에서 생성형 AI 모델을 탐색하고 관리합니다.

- GitHub, ONNX, OpenAI, Anthropic, Google, Ollama 및 사용자 지정 엔드포인트를 포함한 다양한 소스의 모델을 찾습니다.

- 모델을 툴킷에 추가하고 Microsoft Foundry에 배포합니다.

- Ollama 및 OpenAI 호환 모델을 포함한 사용자 지정 모델을 추가하고 플레이그라운드 또는 에이전트 빌더에서 테스트합니다.

- 모델 카탈로그를 사용하여 사용 가능한 모델을 보고 AI 애플리케이션 요구에 가장 적합한 모델을 선택합니다.

- 필터와 검색을 사용하여 모델을 빠르게 찾습니다.

- 인기, GitHub, ONNX, Ollama와 같은 범주별로 모델을 찾아봅니다.

- 모델 변환 도구를 사용하여 사용자 지정 ONNX 모델을 변환하고 추가합니다.

- 내 모델에서 모델을 편집, 삭제, 새로 고침 및 세부 정보 보기 등 관리합니다.

- 로컬 모델의 ONNX 서버를 시작 및 중지하고 엔드포인트를 복사합니다.

- 테스트하기 전에 일부 모델의 라이선스 및 로그인 요구 사항을 처리합니다.